Modernizzare lo stack ML con workflow agentic, multimodali e in tempo reale

Il machine learning tradizionale (ML) resta fondamentale nel panorama AI di oggi, costituendo la base degli insight predittivi che generano valore per il business, dall’ottimizzazione della supply chain al rilevamento delle frodi in tempo reale. Tuttavia, il percorso dalla sperimentazione alla produzione resta complesso, con strumenti frammentati tra ecosistemi che richiedono setup articolati, più iterazioni di ottimizzazione e manutenzione continua. In Snowflake ci impegniamo a offrire una piattaforma ML moderna, strettamente integrata con i dati, con sicurezza unificata e workflow accelerati che scalano con le esigenze del business.

Siamo entusiasti di annunciare che le seguenti funzionalità sono ora disponibili per i workflow dei modelli in Snowflake ML:

Automatizzare lo sviluppo di pipeline ML completamente funzionanti con semplici prompt in linguaggio naturale da un ambiente basato su Jupyter in Snowflake Notebooks (GA) con Cortex Code in Snowsight (generalmente disponibile a breve)

Distribuire in modo efficiente il modello con le prestazioni migliori utilizzando Experiment Tracking integrato in modo nativo (GA) per identificare, condividere e riprodurre facilmente i risultati migliori tra i training run

Servire previsioni a bassa latenza in millisecondi con Snowflake Feature Store online (GA) e inferenza ML online (GA) per casi d’uso in tempo reale come raccomandazioni personalizzate e rilevamento delle frodi

Eseguire workload di inferenza per modelli multimodali (public preview) per inferenza su larga scala con dati non strutturati come immagini e audio

Sviluppo di modelli agentic

In Snowflake continuiamo a investire in esperienze di sviluppo moderne che aumentano la produttività degli sviluppatori. Oggi ripensiamo l’ML di produzione con il lancio di funzionalità di agentic ML integrate con una nuova esperienza IDE in Snowflake Notebooks.

Cortex Code per pipeline ML

I data scientist spesso dedicano cicli lunghi allo sviluppo e alla risoluzione dei problemi nei workflow ML, con colli di bottiglia operativi e un numero inferiore di modelli ML che arriva in produzione. Ora Snowflake porta l’agentic AI nei workflow ML con Cortex Code in Snowsight (GA a breve) per i workflow ML in Snowflake Notebooks, così da iterare, adattare e generare in modo autonomo una pipeline ML completamente eseguibile a partire da semplici prompt in linguaggio naturale.

Cortex Code scompone i problemi legati ai workflow ML in passaggi distinti, come analisi dei dati, preparazione dei dati, feature engineering e training. Combinando tecniche avanzate come ragionamento multi-step, comprensione contestuale ed esecuzione di azioni, Cortex Code fornisce soluzioni verificate sotto forma di pipeline ML completamente funzionanti, facilmente eseguibili da un Notebook Snowflake. Con i miglioramenti suggeriti o con follow-up forniti dagli utenti, Cortex Code aiuta a iterare con facilità verso la versione successiva più efficace. Automatizzando questo lavoro ripetitivo, i team di data science risparmiano ore che normalmente dedicherebbero a sperimentazione o debugging e possono invece concentrarsi su iniziative a maggiore impatto.

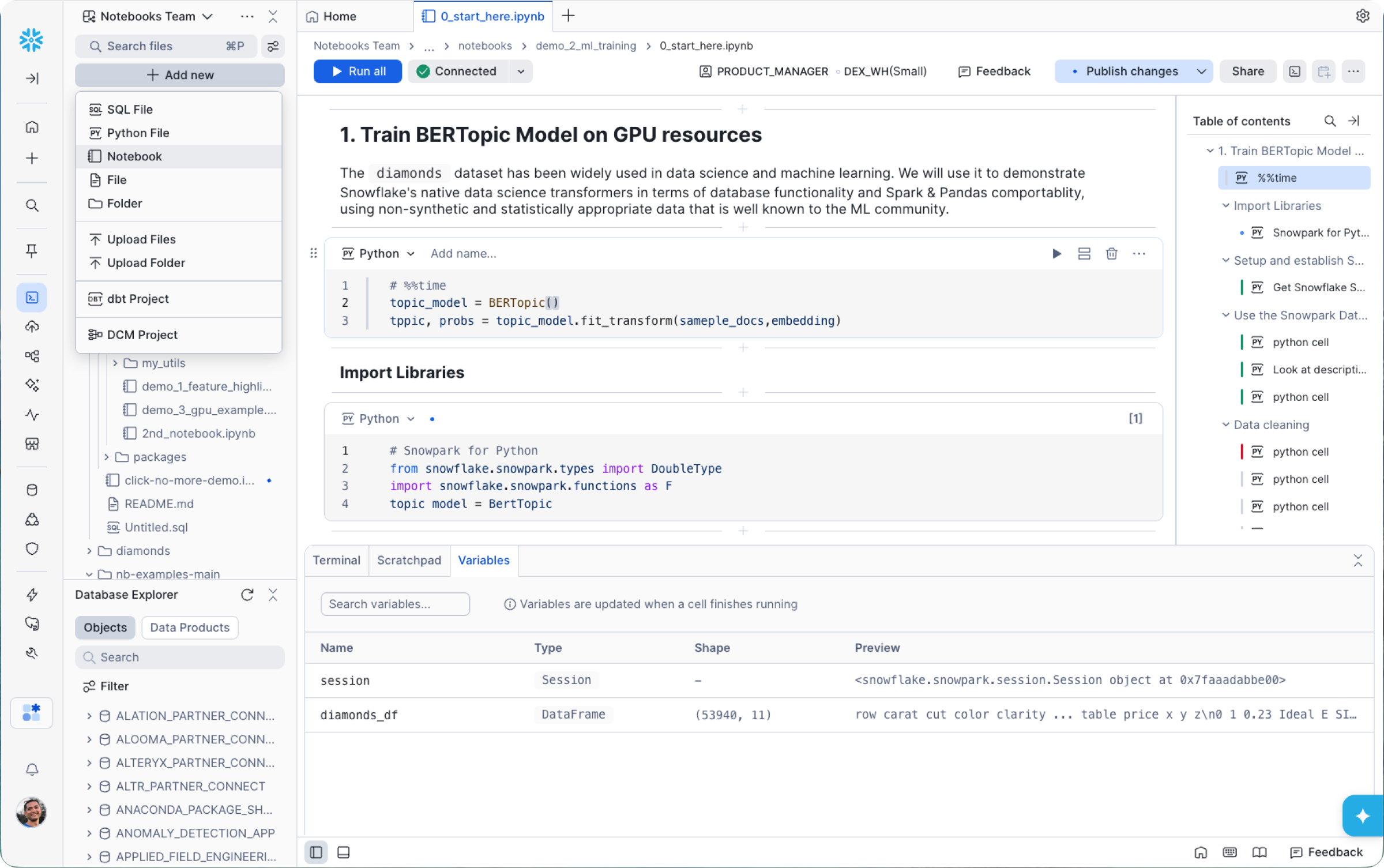

Snowflake Notebooks

Cortex Code può essere utilizzato direttamente da Snowflake Notebooks per creare e iterare workflow di produzione. Lo sviluppo di nuova generazione per Snowflake Notebooks è ora GA in Workspaces. Con questi notebook basati su Jupyter, puoi portare notebook, script e training dei modelli esistenti nella piattaforma unificata Snowflake mantenendo le librerie preferite, le funzionalità del runtime Jupyter e le caratteristiche IDE familiari, oltre all’organizzazione basata su file all’interno di Workspaces.

Questa nuova esperienza di sviluppo include i seguenti miglioramenti:

Kernel Jupyter/IPython gestito: I notebook ora vengono eseguiti su un kernel Jupyter/IPython gestito da Snowflake, garantendo compatibilità con i magics e con i notebook esistenti. Questo include l’esecuzione di codice SQL, Python e Markdown e il trasferimento semplice dei dati tra le celle. Visualizza i risultati in Results Explorer sotto ogni cella, con tabelle e un builder per le visualizzazioni.

Organizzazione nativa in Workspaces: Ora puoi creare notebook direttamente in Workspaces insieme ai file SQL, ai progetti dbt, alle utility Python e a qualsiasi altro asset che utilizzi per sviluppare su Snowflake. Questo ti permette di organizzare tutto in un unico posto e rende naturali i workflow multi-file. Puoi fare il refactoring della logica in helper, suddividere i flussi in componenti più piccoli e combinarli in base alle esigenze. Il nuovo terminale e l’explorer delle variabili offrono inoltre un ciclo di sviluppo più rapido e produttivo.

Collaborazione fluida basata su Git: I Workspaces con integrazione Git ti permettono di lavorare senza attriti sull’intero repository, con branching, commit e diff direttamente da Snowflake. E se Git non è il tuo workflow preferito, Shared Workspaces offre un’alternativa per i team: collaborazione su un set di file governata da controllo degli accessi basato sui ruoli, con versioning e tracciamento delle modifiche integrati.

Possibilità di esecuzione su Snowflake Container Runtime (CPU e GPU): La nuova esperienza gira esclusivamente su Snowflake Container Runtime, un ambiente predefinito per data science e machine learning eseguito direttamente su Snowpark Container Services. Offre framework ML diffusi e più versioni di Python e accelera training e caricamento dati distribuendo le risorse di calcolo. La versione del runtime che utilizzi per prototipare è la stessa che userai per pianificare ed eseguire in produzione, eliminando i classici problemi del tipo “ma sul mio laptop funzionava…”.

Aziende globali come Aimpoint Digital, leader nella consulenza data e AI, utilizzano Snowflake Notebooks per sviluppare workflow pronti per la produzione.

“Il lancio di Snowflake Notebooks rivoluziona l’esperienza di sviluppo. Siamo stati in grado di sviluppare e produrre facilmente workload ML, dal pricing dinamico alla previsione del comportamento degli utenti basata su grafici, per i nostri clienti. Lo sviluppo su notebook all'interno di Workspaces consente di centralizzare il codice comune, decentralizzando al contempo ciò che crea lo sviluppatore. La possibilità di fare riferimento alle celle SQL in Python e viceversa, e di parametrizzare i notebook, rappresenta un vero e proprio cambiamento di paradigma. Sono finiti i tempi della pianificazione delle stored procedure: i notebook offrono la massima flessibilità per flussi di lavoro dinamici, che si tratti di ML, AI o engineering."

Christopher Marland

Per iniziare con Snowflake Notebooks, prova questo quickstart sul topic modeling.

Experiment Tracking

Dopo aver creato e iterato con Snowflake Notebooks e Cortex Code, puoi passare rapidamente dall’ipotesi a un modello ad alte prestazioni con Experiment Tracking integrato in modo nativo (ora GA). Questo consente ai team ML di identificare, condividere e riprodurre in modo sistematico i modelli con le prestazioni migliori tra i training run. Semplifica la collaborazione, migliora la riproducibilità e accelera le iterazioni dei modelli in tutta l’azienda. Con l’ultima release di Experiment Tracking di Snowflake, puoi registrare senza soluzione di continuità milioni di metriche generate durante training run su larga scala insieme a parametri del modello, artifact e metadati.

Molte aziende utilizzano Experiment Tracking per archiviare, tracciare e confrontare informazioni critiche sull’addestramento tra run, inclusa EnergyHub, che consente alle utility e ai loro clienti di costruire un futuro energetico pulito e distribuito.

“Come primi utilizzatori di Snowflake Experiment Tracker, abbiamo riscontrato che soddisfa le nostre esigenze, eliminando al contempo la necessità di mantenere un server MLFlow separato. Il consolidamento del monitoraggio degli esperimenti di ML all'interno della nostra piattaforma Snowflake è stato una significativa vittoria operativa. Inoltre, Snowflake ha dimostrato una straordinaria reattività ai feedback, implementando miglioramenti a un ritmo impressionante.”

Dr. Wiliam Franklin

Serving in tempo reale

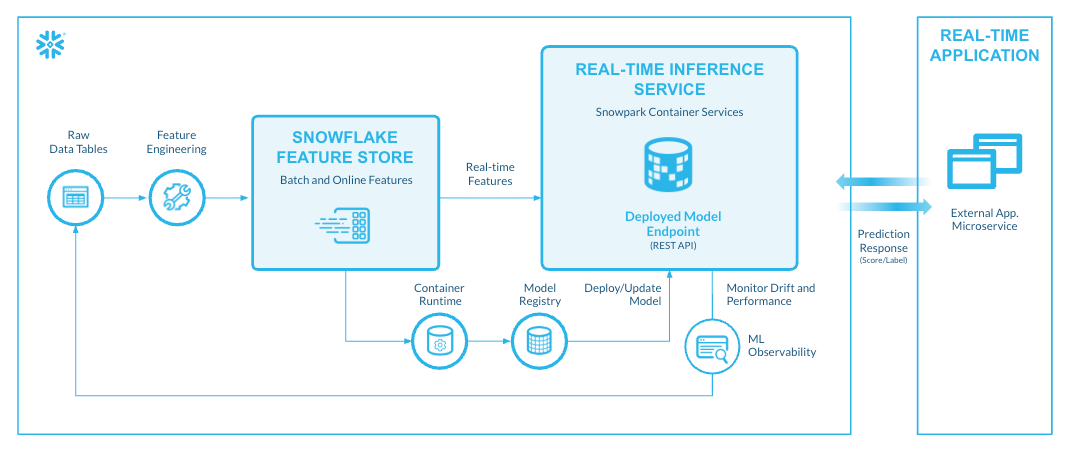

Una volta addestrato il modello in Snowflake o su qualsiasi altra piattaforma esterna, puoi distribuirlo facilmente per l’inferenza sui dati Snowflake e generare risultati predittivi. Stiamo introducendo nuove funzionalità ML online pronte per la produzione, ora generalmente disponibili, per abilitare casi d’uso in tempo reale come raccomandazioni personalizzate e rilevamento delle frodi, senza infrastrutture aggiuntive o configurazioni complesse. Gli sviluppatori possono ora eliminare latenza, costi e rischi di sicurezza legati all’esportazione di dati sensibili verso piattaforme esterne, unificando casi d’uso ML batch e online su un’unica piattaforma.

Snowflake Feature Store

Siamo entusiasti di annunciare la general availability di online feature serving in Snowflake Feature Store. Snowflake Feature Store è una soluzione integrata per data scientist e ML engineer per creare, archiviare, gestire e servire feature ML per training e inferenza dei modelli. Include API Python e interfacce SQL per definire, gestire e recuperare feature, insieme a infrastruttura gestita per la gestione dei metadati delle feature e l’elaborazione continua delle feature. Con la funzionalità di online feature serving, Snowflake Feature Store funge da soluzione unificata per casi d’uso batch e online a bassa latenza, servendo le feature in 30 ms.

Snowflake Feature Store è integrato in modo nativo con dati, feature e modelli in Snowflake, così pipeline ML su larga scala possono essere portate in produzione in modo semplice ed efficiente. Questo elimina ridondanze e duplicazioni nelle pipeline di feature, garantendo feature coerenti, aggiornate e accurate, disponibili con sicurezza e governance di livello enterprise. Un’interfaccia utente centralizzata in Snowsight per il serving del feature store rende semplice cercare e scoprire feature e modelli e visualizzare il flusso dei dati tramite lineage.

Puoi iniziare oggi con Snowflake Feature Store per l’online feature serving provando questo quickstart.

Inferenza ML online

Online ML inference è ora GA, consentendo di servire modelli dal Snowflake Model Registry per inferenza in tempo reale in meno di 100 ms.

Per soddisfare le esigenze rigorose dei workload di produzione, l’inferenza ML online integra autoscaling intelligente, prestazioni a bassa latenza e osservabilità completa in un workflow coerente. Si parte da prestazioni efficienti in termini di costi: la logica di autoscaling gestisce istantaneamente grandi picchi di traffico e scala a zero quando la domanda diminuisce, eliminando l’overhead costoso di GPU sovradimensionate. Inoltre, quando il traffico torna a crescere, il sistema è progettato per reagire immediatamente, assicurando che i modelli scalino rapidamente per mantenere prestazioni sotto i 100 ms.

Il deployment è altrettanto resiliente: gli utenti possono passare a nuove versioni del modello tramite rolling update automatizzati che garantiscono che il traffico applicativo non venga mai interrotto, con la sicurezza di rollback di versione semplici. I team possono inoltre sfruttare la shadow mode per validare in sicurezza nuovi modelli monitorandone le prestazioni in un ambiente parallelo, isolato dalla versione di produzione, prima di procedere al cutover completo. Snowflake rende anche semplice ottenere visibilità out-of-the-box su latenza, throughput e tassi di errore con un’osservabilità integrata che registra tutte le richieste e le risposte direttamente in una tabella Snowflake, per debugging approfondito e auditing di lungo periodo.

Inferenza per modelli multimodali

Inoltre, eseguire inferenza online e batch su larga scala è ora semplice con il supporto di Snowflake all’inferenza per modelli multimodali open source da hub come Hugging Face. Il supporto all’inferenza per dati non strutturati è ora in public preview e include tipi di dati come immagini, video e audio. Questa funzionalità abilita casi d’uso AI come object detection, visual Q&A e riconoscimento automatico del parlato in Snowflake, senza pipeline complesse o spostamenti di dati.

Snowflake supporta sia esigenze di elaborazione in tempo reale sia batch. Gli utenti possono distribuire modelli multimodali come servizio per inferenza online tramite API REST oppure registrarli nel Snowflake Model Registry per invocazioni batch immediate. Sfruttando il layer di calcolo distribuito di Snowflake, i team possono eseguire enormi attività di inferenza su grandi data set senza uscire dal proprio ambiente abituale.

Per iniziare

Con l’ultima ondata di innovazioni nelle funzionalità agentic, online e multimodali, Snowflake ML accelera ulteriormente il percorso dal prototipo alla produzione sulla stessa piattaforma dei dati governati.

Consulta la nostra documentazione di prodotto e prova Snowflake ML oggi con questo quickstart introduttivo utilizzando la versione trial gratuita di 30 giorni.