Die neue Welle generativer KI nutzen – mit GPU-gestützten Rechenressourcen von Snowpark Container Services

Die Verbreitung generativer KI (GenAI) inspiriert Geschäftsführungen auf der ganzen Welt: Sie stellen sich eine Zukunft vor, in der KI in sämtliche Aspekte des Betriebs integriert ist, um eine menschlichere, stärker personalisierte und effizientere Kundenerfahrung zu bieten. Doch die erforderliche Computing-Infrastruktur einzurichten – insbesondere die GPUs, die für Large Language Models (LLMs) benötigt werden –, ist eine echte Herausforderung. Der Zugang zu den nötigen Ressourcen von Cloud-Anbietern erfordert sorgfältige Planung und aufgrund des hohen GPU-Bedarfs müssen Unternehmen hierbei mit Wartezeiten von bis zu mehreren Monaten rechnen. Und auch wenn die GPUs einmal beschafft sind, erfordert der Betrieb dieser Infrastruktur nicht nur spezielles Fachwissen, sondern steigert außerdem die Gemeinkosten, was wiederum die Bereitstellung von Innovationen einschränken kann.

Wir wollen Unternehmen dabei unterstützen, komplexe Visionen in die Tat umzusetzen – mit einfachem Zugang zu einer GPU-Infrastruktur, aber ohne zusätzliche betriebliche Gemeinkosten. Deshalb bieten wir Kunden über die serverlosen Funktionen in Snowflake Cortex (in Private Preview) Zugang zu branchenführenden LLMs. Und wir freuen uns, Ihnen die Public Preview von Snowpark Container Services anzukündigen. Hiermit erhalten Entwicklungsteams elastische On-Demand-Rechenressourcen – dank GPUs für alle Arten der benutzerdefinierten LLM-App-Entwicklung sowie für jeden anderen innovativen Anwendungsfall.

Mit der Public Preview dieser neuen Snowpark-Laufzeitumgebung können Entwickler:innen mühelos Container-Images in ihrem Snowflake-Konto registrieren und bereitstellen. Hierdurch erhalten Kunden mit hohen Kapazitätsanforderungen schnellen Zugang zu der nötigen GPU-Infrastruktur. Sie müssen die Instanzen nicht selbst beschaffen oder erst bei ihrem Public-Cloud-Anbieter reservieren.

In Sachen generativer KI unterstützt diese neue Snowpark-Laufzeitumgebung Entwicklungsteams dabei, Container auf effiziente und sichere Weise bereitzustellen. So lässt sich unter anderem Folgendes erzielen:

- LLM-Optimierung

- Bereitstellung von Open-Source-Vektordatenbanken

- Verarbeitung von verteilter Einbettung

- Sprache-zu-Text-Transkription

Warum hat Snowflake einen Containerservice entwickelt?

Um die Fähigkeiten der Snowflake-Engine so zu erweitern, dass sie mehr als nur SQL-basierte Workloads unterstützt, haben wir Snowpark eingeführt. Diese Lösung sorgt dafür, dass auch Python, Java und Scala in der Rechenumgebung virtueller Warehouses eingesetzt werden können. Und um die Flexibilität auf praktisch jede Programmiersprache, jedes Framework, jede Bibliothek und jede Hardware auszuweiten – einschließlich GPUs –, haben wir Snowpark Container Services entwickelt.

Dadurch, dass Snowflake auch weiterhin die Rechenleistung zu den Daten bringt, entfällt für Entwickler:innen die zusätzliche Arbeit für die Pipeline-Entwicklung und -Verwaltung. Außerdem gibt es weniger Latenzen in Zusammenhang mit dem Verschieben großer Datenmengen auf separate Plattformen. Und da Snowpark Container Services speziell für datenintensive Verarbeitung entwickelt wurde, können Entwicklungsteams mühelos Millionen von Datenzeilen laden und verarbeiten.

So tut es beispielsweise auch das Engineering-Team von SailPoint: Dessen Identitätssicherheitsmodell erforderte früher eine komplexe Orchestrierungs-Pipeline – heute muss das Team hierfür nur noch einen einzigen Task ausführen. Wenn Sie mehr darüber wissen möchten, welche Erfahrungen dieses Team mit Snowpark Container Services gemacht hat, lesen Sie diese zweiteilige Blogreihe (Teil 1, Teil 2).

Was macht Snowpark Container Services einzigartig?

Integrierte Governance: Snowpark Container Services wird im selben Snowflake Horizon-Governance-Framework ausgeführt wie Ihre Daten. Durch die einheitliche Governance für Daten und Rechenressourcen können Entwickler:innen auf unkomplizierte Weise sicherstellen, dass ihre Daten geschützt sind, und so Sicherheitsprüfungen für neue Entwicklungen optimieren.

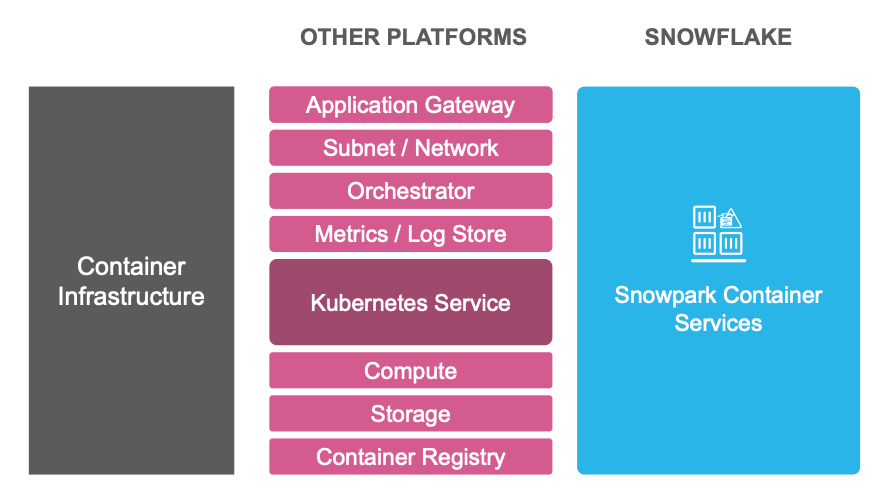

Einheitliche Service-Erfahrung: Snowpark Container Services verringert den Verwaltungsaufwand bei der Bereitstellung von Containern. Hierzu bietet die Lösung eine integrierte Image-Registry, eine elastische Computing-Infrastruktur, einen verwalteten Kubernetes-basierten Cluster sowie andere Services, die zum Ausführen von Containern in der Produktion erforderlich sind (siehe Abbildung 1).

Optimiertes Preismodell: Die integrierte Service-Erfahrung ermöglicht auch ein verbessertes Preismodell. Bei Snowpark Container Services werden nur Rechen- und Speicherressourcen berechnet. Das heißt, es gibt keine separate Rechnung für Registry, Gateway, Protokolle und alle anderen Ressourcen, die Sie für die Bereitstellung in der Produktion benötigen.

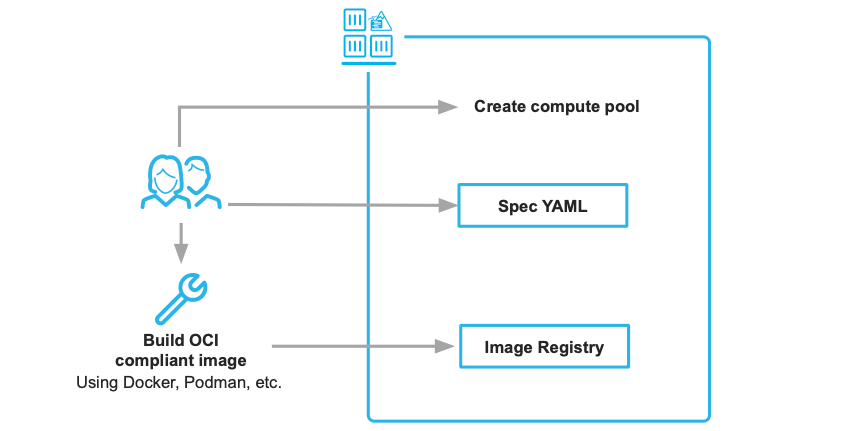

Und das Beste: Sie brauchen nur zwei Artefakte, um ein Container-Image aus Ihrer Entwicklungsumgebung in einen skalierbaren Cloud-Service zu verwandeln, und zwar das Container-Image sowie eine YAML-Datei mit Spezifikationen.

Welche technischen Verbesserungen wurden während der Private Preview vorgenommen?

- Verstärkte Sicherheit und Governance: Wir haben die Kontrolle über Sicherheitsaspekte verbessert, darunter Dateneingang und -ausgang sowie Networking. Registrieren Sie sich hier, um in unserem anstehenden Tech Talk zum Thema Sicherheit mehr über dieses Thema zu erfahren.

- Erweiterte Speicheroptionen: Wir haben vielfältigere Speicherlösungen hinzugefügt, darunter lokale Volumes, Arbeitsspeicher und Snowflake-Stages. Darüber hinaus fügen wir auch Blockspeicher hinzu (derzeit in Private Preview).

- Vielfältigere Instanztypen: Wir haben arbeitsspeicherintensive Instanzen und dynamische GPU-Zuteilung hinzugefügt, um anspruchsvolle Workloads zu unterstützen.

Sind Sie bereit?

Das Team arbeitet intensiv daran, Snowpark Container Services in sämtlichen AWS-Regionen verfügbar zu machen – die Unterstützung für andere Clouds folgt zu einem späteren Zeitpunkt.

Im Folgenden finden Sie einige Ressourcen für den Einstieg:

- Stellen Sie Ihren ersten Container in Snowflake bereit (Hinweis: Snowpark Container Services ist im Rahmen kostenloser Testversionen nicht verfügbar). Quickstart

- Erhalten Sie eine Benachrichtigung, sobald neue Regionen verfügbar werden. Github

- Erfahren Sie mehr über Snowpark Container Services. Dokumentation

- Finden Sie heraus, wie die Kombination aus Snowpark ML und Snowpark Container Services die LLM-Bereitstellung vereinfacht. Demo

- Erfahren Sie in einem Tech Talk mit dem VP of Product von Landing AI mehr über die Zukunft von KI-Apps in Unternehmen. Registrieren

Wir freuen uns darauf, all die großartigen Dinge zu sehen, die Sie in der Data Cloud mithilfe der nahezu grenzenlosen Flexibilität dieser neuen Laufzeitumgebung entwickeln werden.