Sfrutta il potenziale della Gen AI con la capacità di elaborazione basata su GPU di Snowpark Container Services

L’AI generativa (Gen AI) sta spingendo le organizzazioni a immaginare un futuro in cui l’intelligenza artificiale sia integrata in tutti gli aspetti operativi, per offrire una customer experience più umana, personalizzata e performante. Tuttavia, l’effettiva implementazione dell’infrastruttura di elaborazione richiesta, e in particolare delle GPU per i large language model (LLM), è una vera sfida. A causa dell’elevata domanda di GPU, l’accesso alle risorse necessarie da parte dei cloud provider richiede una pianificazione attenta e tempi di attesa che possono arrivare fino a un mese. Inoltre, una volta ottenute le GPU, l’utilizzo e la gestione dell’infrastruttura richiedono esperienze specializzate e comportano un aumento dei costi generali, limitando potenzialmente lo sviluppo dell’innovazione.

Per aiutare le organizzazioni a realizzare una visione così complessa, che prevede facile accesso a un’infrastruttura GPU senza costi operativi aggiuntivi, Snowflake offre ai clienti l’accesso a LLM leader del settore grazie alle funzionalità serverless di Snowflake Cortex (in private preview). Oggi siamo lieti di annunciare la public preview di Snowpark Container Services, che offre agli sviluppatori una capacità di elaborazione elastica, on demand e basata su GPU per lo sviluppo di tutti i tipi di app LLM personalizzate e per casi d’uso avanzati.

Questo nuovo runtime Snowpark in public preview consente agli sviluppatori di registrare e distribuire in modo immediato immagini container nel proprio account Snowflake, offrendo ai clienti con un contratto Capacity un rapido accesso all’infrastruttura GPU. Non è infatti necessario procurare autonomamente le istanze o effettuare prenotazioni con il proprio cloud provider.

Nell’ambito dell’intelligenza artificiale generativa, questo nuovo runtime Snowpark consente agli sviluppatori di implementare i container in modo efficiente e sicuro per operazioni come queste, e non solo:

Perché Snowflake ha creato un servizio container?

Per espandere le capacità del motore Snowflake oltre i workload basati su SQL, Snowflake ha lanciato Snowpark, che aggiunge il supporto per Python, Java e Scala all’interno dei virtual warehouse. Inoltre, per estendere la flessibilità a praticamente tutti i linguaggi, i framework e le librerie oltre all’hardware preferito, CPU incluse, Snowflake ha creato Snowpark Container Services.

Snowflake continua a portare la capacità di elaborazione dove si trovano i dati, evitando agli sviluppatori di dover sviluppare e gestire pipeline aggiuntive e riduce inoltre la latenza dei trasferimenti di volumi elevati di dati su piattaforme separate. Essendo progettato per un’elaborazione ad alta intensità di dati, Snowpark Container Services consente agli sviluppatori di caricare ed elaborare senza problemi milioni di righe di dati.

È il caso del team di engineering di Sailpoint, che ha visto il proprio modello di sicurezza basato sull’identità passare da una complessa pipeline di orchestrazione a un singolo task di esecuzione. Puoi scoprire di più sull’esperienza di sviluppo di Sailpoint con Snowpark Container Services in questi due blog: parte 1 e parte 2.

Cosa rende unico Snowpark Container Services?

Governance integrata: Snowpark Container Services funziona nello stesso framework di governance dei dati Snowflake Horizon. Avere la stessa governance per dati e capacità di calcolo consente agli sviluppatori di verificare più facilmente se i dati sono protetti per semplificare le analisi della sicurezza per le nuove attività di sviluppo.

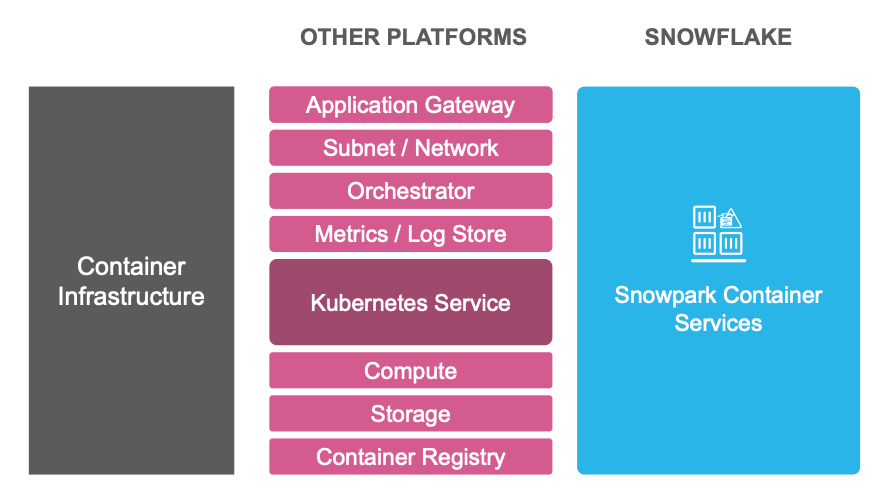

Servizi unificati: Snowpark Container Services riduce il carico operativo connesso allo sviluppo dei container grazie a un Image Registry integrato, a un’infrastruttura di elaborazione elastica e a cluster Kubernetes gestiti oltre agli altri servizi necessari per eseguire i container in produzione (vedi la figura 1).

Pricing semplificato: i servizi integrati hanno anche un pricing più semplice. Gli unici costi di Snowpark Container Services sono per la capacità di elaborazione e di archiviazione, non sono previsti addebiti aggiuntivi per registro, gateway, log e per tutto quanto necessario per le implementazioni in produzione.

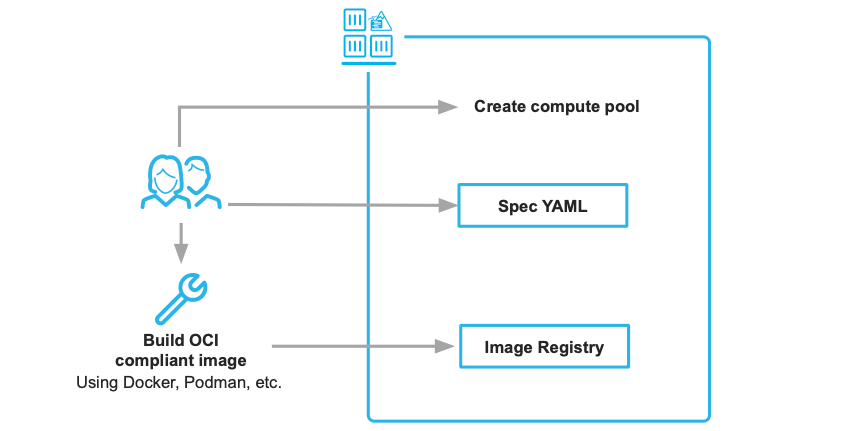

Ma il vantaggio principale è che per passare da un’immagine container nell’ambiente di sviluppo a un servizio scalabile nel cloud sono sufficienti due artefatti: l’immagine container e un file di specifiche YAML.

Quali miglioramenti tecnici sono stati apportati durante la private preview?

- Sicurezza e governance migliorate: abbiamo potenziato il controllo sugli aspetti della sicurezza, inclusi ingresso, uscita e networking. Registrati qui per seguire il prossimo Tech Talk di approfondimento sulla sicurezza.

- Nuove opzioni di archiviazione: abbiamo aggiunto varie altre soluzioni di archiviazione, tra cui volumi locali, memoria e Stages di Snowflake, soluzioni che stiamo espandendo per includere il block storage (attualmente in private preview).

- Più tipi di istanze diverse: abbiamo introdotto istanze a memoria elevata e allocazione dinamica delle GPU per i workload intensivi.

Scopriamo subito come iniziare.

Il team sta lavorando per rendere Snowpark Container Services disponibile al più presto in tutte le regioni AWS, con il supporto di altri cloud a seguire.

Ecco alcune risorse utili per iniziare:

- Implementa il tuo primo container in Snowflake (nota: Snowpark Container Services non è disponibile per gli account di prova gratuita). Quickstart

- Ricevi una notifica quando diventano disponibili nuove regioni. Github

- Scopri di più su Snowpark Container Services. Documentazione

- Scopri come Snowpark ML più Snowpark Container Services semplifica la distribuzione dei LLM. Demo

- Partecipa a un Tech Talk sul futuro delle app AI aziendali con il VP of Product di Landing AI. Registrati

Non vediamo l’ora di scoprire tutto quello che stai creando nel Data Cloud con questo nuovo runtime che offre una flessibilità di sviluppo quasi illimitata.