Aprovecha la nueva ola de la IA generativa con el cómputo basado en GPU de Snowpark Container Services

El auge de la IA (inteligencia artificial) generativa permite a las organizaciones vislumbrar un futuro con una experiencia del cliente más humana, personalizada y eficaz, gracias a la integración de la IA en todos sus ámbitos de operación. Sin embargo, implementar la infraestructura de cómputo necesaria, en particular las GPU para large language models (LLM), supone todo un reto. Para acceder a los recursos necesarios de los proveedores de nube, se necesita una cuidadosa planificación y una espera que se puede prolongar varios meses, dada la alta demanda de GPU. Una vez que se dispone de las GPU, operar con la infraestructura requiere experiencia y conocimientos especializados, y conlleva un aumento de los gastos generales, lo que puede llegar a limitar la innovación.

Para ayudar a las organizaciones a hacer realidad una idea tan compleja —un panorama basado en la posibilidad de contar con una infraestructura de GPU de forma sencilla y sin gastos operativos adicionales— Snowflake ofrece a sus clientes acceso a los mejores LLM del sector a través de funciones sin servidor en Snowflake Cortex (en vista previa privada). Hoy nos complace anunciar la vista previa pública de Snowpark Container Services, que proporciona a los desarrolladores una capacidad de cómputo elástica y a petición, con tecnología de GPU para cualquier tipo de desarrollo de aplicaciones de LLM personalizadas y casos de uso avanzados.

Con la vista previa pública de este nuevo entorno de ejecución de Snowpark, que ayuda a los desarrolladores a registrar e implementar fácilmente imágenes de contenedor en sus cuentas de Snowflake, los clientes con limitaciones de capacidad podrán acceder con rapidez a la infraestructura de GPU. No es necesario que adquieran instancias por su cuenta ni que hagan reservas con sus proveedores de nube pública.

Al amparo de la IA generativa, este nuevo entorno de ejecución de Snowpark facilita a los desarrolladores la implantación eficaz y segura de contenedores, lo que les permite, entre otras cosas:

¿Por qué ha creado Snowflake un servicio de contenedores?

Con el objetivo de ampliar las capacidades del motor de Snowflake más allá de los workloads basados en SQL, Snowflake lanzó Snowpark, que incorporaba la compatibilidad con Python, Java y Scala al cómputo en almacenes de datos virtuales. Del mismo modo, para llevar la flexibilidad a prácticamente cualquier lenguaje, marco o biblioteca, así como al hardware preferido del cliente, incluidas las GPU, Snowflake creó Snowpark Container Services.

Gracias a que Snowflake sigue acercando el cómputo a los datos, los desarrolladores pueden eliminar la gestión y el desarrollo de flujos adicionales, así como disfrutar de una menor latencia al mover grandes volúmenes de datos a plataformas independientes. Además, el diseño de Snowpark Container Services está orientado al procesamiento con un uso intensivo de los datos, por lo que los desarrolladores pueden cargar y procesar con facilidad millones de filas de datos.

Es el caso del equipo de ingeniería de Sailpoint, cuyo modelo de seguridad de identidades pasó de un complejo flujo de orquestación a una única tarea de ejecución. Si te interesa conocer su experiencia con Snowpark Container Services, visita estas entradas del blog (parte 1 y parte 2).

¿Qué hace único a Snowpark Container Services?

Gobernanza integrada: Snowpark Container Services se ejecuta en el mismo marco de gobernanza de Snowflake Horizon que los datos. Al tener la misma gobernanza sobre los datos y el cómputo, los desarrolladores pueden garantizar la protección de los datos de una manera mucho más sencilla y, así, agilizar las revisiones de seguridad de los nuevos desarrollos.

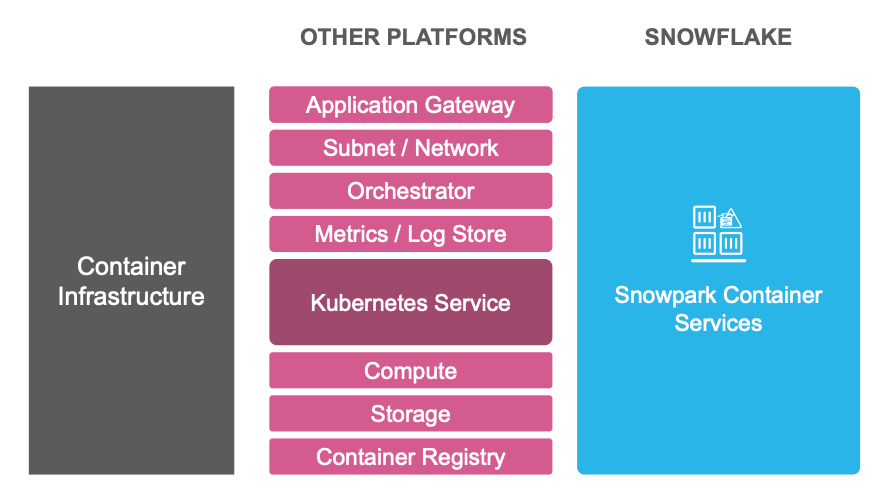

Experiencia de servicios unificada: Snowpark Container Services reduce la carga operativa vinculada a la implementación de contenedores, ya que incluye un registro de imágenes integrado, una infraestructura de cómputo elástico y un clúster gestionado basado en Kubernetes, además de otros servicios necesarios para ejecutar los contenedores en producción (véase la figura 1).

Precio ajustado: la experiencia de servicios integrada también permite ajustar los precios. Snowpark Container Services solo cobra por el cómputo y el almacenamiento, por lo que no se te facturarán el registro, la puerta de enlace, las anotaciones ni cualquier otro elemento necesario para las implementaciones en producción.

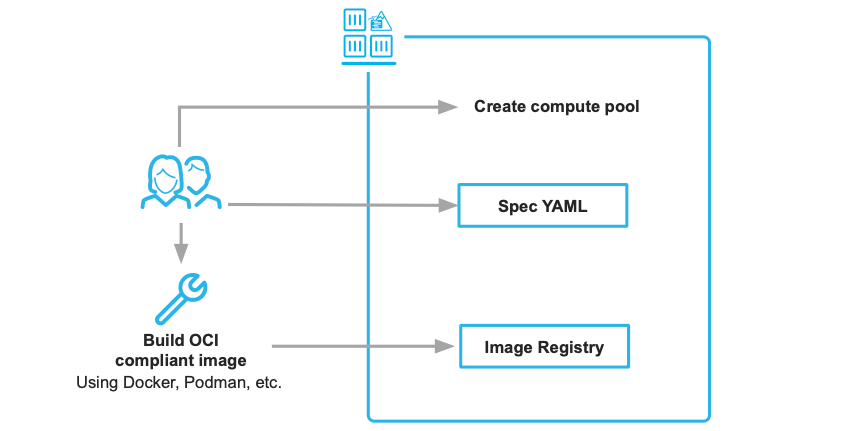

Lo mejor de todo es que lo único que hace falta para pasar de una imagen de contenedor de tu entorno de desarrollo a un servicio escalable en la nube son dos artefactos: la imagen de contenedor y un archivo de especificaciones YAML.

¿Qué mejoras técnicas se han hecho durante la vista previa privada?

- Mejoras en la seguridad y la gobernanza: hemos mejorado el control de las cuestiones relacionadas con la seguridad, incluidas la entrada, la salida y las redes. Regístrate aquí para obtener más información al respecto en la próxima charla técnica exhaustiva sobre seguridad.

- Más opciones de almacenamiento: hemos añadido una mayor variedad de soluciones de almacenamiento, como volúmenes locales, memoria y Snowflake Stages. Además, vamos a seguir ampliando la oferta para incluir el almacenamiento en bloques (actualmente, en vista previa privada).

- Mayor gama de tipos de instancias: hemos añadido instancias con mucha memoria y asignación dinámica de GPU para workloads intensivos.

¿Empezamos?

El equipo está trabajando duro para que Snowpark Container Services esté disponible en todas las regiones de AWS. Además, se prevé que pronto sea compatible también con otras nubes.

Aquí tienes unos cuantos recursos que te ayudarán a empezar:

- Implementa tu primer contenedor en Snowflake. Nota: Snowpark Container Services no está disponible en las cuentas de prueba gratuita. Quickstart

- Recibe una notificación cuando haya nuevas regiones disponibles. Github

- Obtén más información sobre Snowpark Container Services. Documentación

- Descubre cómo la combinación entre Snowpark ML y Snowpark Container Services simplifica la implementación de LLM. Demostración

- Asiste a una charla técnica sobre el futuro de las aplicaciones de IA empresarial impartida por el VP of Product de Landing AI. Regístrate

Estamos deseando ver lo que eres capaz de crear en el Data Cloud con este nuevo entorno de ejecución, que permite disfrutar de una flexibilidad de desarrollo prácticamente ilimitada.