Découvrez Polaris Catalog, un catalogue open source pour Apache Iceberg

Les formats de fichier et de table open source ont suscité beaucoup d’intérêt sur le secteur de la data. Ce succès s’explique par leur grand potentiel en matière d’interopérabilité, qui permet le fonctionnement sécurisé de nombreuses technologies avec une seule copie de données. Non seulement cette interopérabilité étendue réduit la complexité et les coûts associés à l’utilisation simultanée de nombreux outils et moteurs de traitement, mais elle évite également les risques liés à une éventuelle dépendance aux fournisseurs.

Malgré une adoption rapide des formats de fichier et de table open source, de nombreuses limites interdépendantes existent entre les moteurs et les catalogues, créant ainsi une dépendance qui déprécie les normes ouvertes d’Iceberg. Les ingénieurs et les architectes data doivent alors composer avec ces contraintes et trouver le juste équilibre entre complexité et dépendance. Dans le but d’améliorer l’interopérabilité, la communauté Apache Iceberg a développé une norme ouverte d’un protocole REST dans le cadre du projet Iceberg. La spécification API ouverte représente un pas de géant pour l’interopérabilité, tandis que l’écosystème peut tirer parti de la mise en œuvre du catalogue open source pour disposer d’un stockage indépendant des fournisseurs.

Aujourd’hui, Snowflake est ravi de lancer Polaris Catalog, qui offre aux entreprises et à la communauté Iceberg des niveaux inédits de choix, de flexibilité et de contrôle à l’égard de leurs données. Elles bénéficient en outre d’une sécurité complète et de l’interopérabilité d’Apache Iceberg avec Amazon Web Services (AWS), Confluent, Dremio, Google Cloud, Microsoft Azure, Salesforce et d’autres encore. Polaris Catalog s’appuie sur les normes créées par la communauté Iceberg pour relever les défis évoqués plus haut.

- Au lieu de déplacer et de copier les données sur différents moteurs et catalogues, vous pouvez utiliser la même copie de données stockée dans un seul et même emplacement avec vos différents moteurs.

- Vous pouvez l’héberger dans l’infrastructure gérée de Snowflake ou dans l’infrastructure de votre choix.

Disponible en open source dans les 90 prochains jours, Polaris Catalog sera également proposé prochainement en public preview dans l’infrastructure de Snowflake. Poursuivez votre lecture pour en savoir plus sur les fonctionnalités et options d’hébergement.

Interopérabilité en lecture et en écriture entre les moteurs

De nombreuses entreprises utilisent plusieurs moteurs de traitement pour exécuter des charges de travail spécifiques ou sont à la recherche de flexibilité pour ajouter ou interchanger facilement les moteurs de traitement à l’avenir. Dans les deux cas, elles souhaitent pouvoir utiliser une seule et même copie de données sur plusieurs moteurs, en toute liberté et de manière sécurisée, afin de réduire les coûts de stockage et de calcul associés au déplacement des données ou à la gestion de plusieurs copies de celles‑ci.

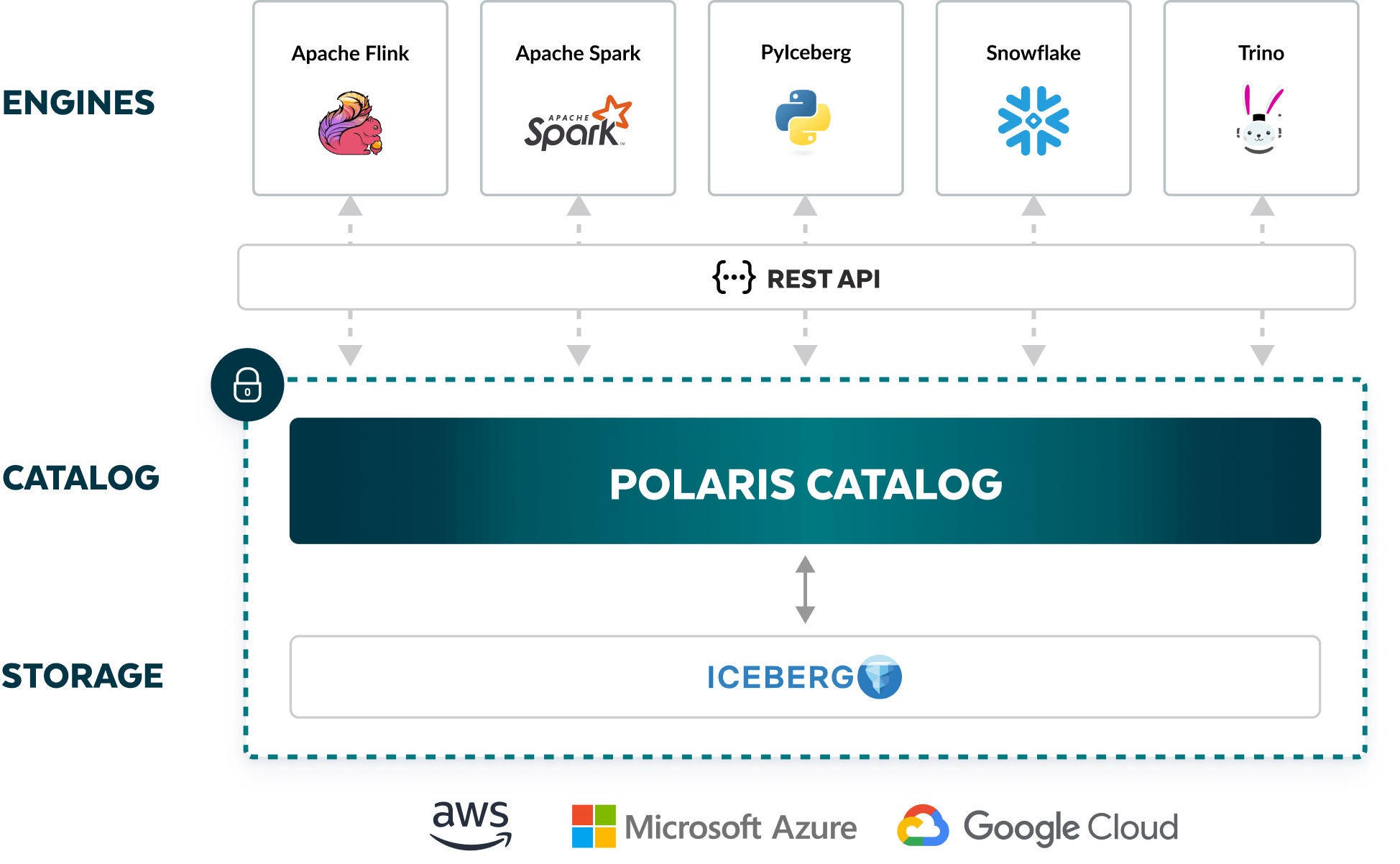

Les catalogues jouent un rôle stratégique dans une architecture comportant plusieurs moteurs. Les actions appliquées aux tables gagnent en flexibilité, grâce à la prise en charge des opérations atomiques. Ainsi, les data engineers et leurs pipelines peuvent modifier les tables simultanément, et les requêtes lancées sur ces tables produisent des résultats précis. Dans cette optique, toutes les opérations en lecture et en écriture des Iceberg Tables, même si elles proviennent de moteurs différents, sont acheminées via un catalogue.

Un protocole de catalogue standardisé pour tous les moteurs permet une interopérabilité entre plusieurs moteurs. Heureusement, la communauté Apache Iceberg a créé une spécification open source pour un protocole REST. Grâce à ce gain d’interopérabilité, un nombre croissant de catalogues et de moteurs, qu’ils soient open source ou commercialisés, prennent en charge cette spécification API REST.

Polaris Catalog met en œuvre l’API REST ouverte d’Iceberg pour maximiser le nombre de moteurs qu’il est possible d’intégrer. Aujourd’hui, cela inclut Apache Doris, Apache Flink, Apache Spark, PyIceberg, StarRocks et Trino. D’autres options commerciales, telles que Dremio, sont prévues à l’avenir. Vous pouvez également utiliser Snowflake pour les opérations de lecture et d’écriture depuis et vers les Iceberg Tables avec Polaris Catalog, grâce à la prise en charge étendue de Snowflake pour les intégrations de catalogue avec l’API REST d’Iceberg (bientôt en public preview).

Exécuter partout, sans dépendance

Vous pouvez vous lancer en exécutant la solution Polaris Catalog open source hébergée sur l’infrastructure AI Data Cloud de Snowflake (bientôt en public preview), ou réaliser l’hébergement sur votre propre infrastructure (prochainement) à l’aide de conteneurs tels que Docker et Kubernetes. Quel que soit le mode de déploiement de Polaris Catalog que vous choisissez, vous ne souffrez aucune dépendance. Et si vous souhaitez remplacer votre infrastructure sous‑jacente, rien ne vous en empêche.

Étendre la gouvernance de Snowflake Horizon grâce à l’intégration de Polaris Catalog

Une fois Snowflake Horizon et Polaris Catalog intégrés, les capacités de gouvernance et de découverte de Snowflake Horizon, telles que Column Masking Policies, Row Access Policies, Object Tagging et Sharing, viennent compléter Polaris Catalog. Ainsi, si des Iceberg Tables sont créées dans Polaris Catalog par Snowflake ou un autre moteur, tel que Flink ou Spark, vous pouvez étendre les fonctionnalités de Snowflake Horizon à ces tables comme s’il s’agissait d’objets Snowflake natifs.

Un système tourné vers l’avenir

Polaris Catalog est conçu pour fournir aux clients de Snowflake, mais aussi à tous les maillons de l’écosystème de la data, un stockage parfaitement interopérable en s’appuyant sur les normes de la communauté Apache Iceberg. Forts de notre expérience dans l’exécution d’une plateforme cross‑cloud mondiale avec le soutien de l’incroyable communauté d’Iceberg, qui n’a de cesse de grandir, nous continuerons à améliorer Polaris Catalog. Si vous souhaitez en savoir plus sur Polaris Catalog, n’hésitez pas à assister au AI Data Cloud Summit ou à vous inscrire à ce webinaire. Pour avoir la primeur de la date de sortie du code pour Polaris Catalog, activez les notifications en regardant ce référentiel GitHub.

Déclarations prévisionnelles

Cet article contient des déclarations prévisionnelles, notamment de futures offres de produits. Il ne constitue en aucun cas un engagement à fournir des offres de produits. Les offres et résultats réels peuvent varier et faire l’objet de risques connus et inconnus, ainsi que d’incertitudes. Découvrez notre dernier 10‑Q pour en savoir plus.