Snowflake Cortex AIは、ノーコード開発、サーバーレスのファインチューニング、マネージドサービスによりエンタープライズAIを進化させ続け、データアプリケーションとのチャットを構築

生成AIは、企業に大きな変革をもたらします。企業は生成AIを活用してデータからより多くの価値を抽出し、顧客アプリケーションと従業員アプリケーションのための対話型インターフェイスを構築できます。AIソリューションを採用することで、全体的な効率を高めることができます。生成AIにより、従業員はエンタープライズグレードのタスクをより迅速かつ正確に実行し、生産性とエンゲージメントを高めることができます。さらに、堅牢なデータセキュリティコントロールを導入し、規制要件を満たすことで、企業はコンプライアンス基準を満たしながら、自信を持ってAIを統合できます。社内のAIに関する専門知識の欠如に対処し、AIプロセスを簡素化すれば、導入が容易になります。これらの機会を活用することで、企業は生成AIを使用してより大きな成功を収めることができます。

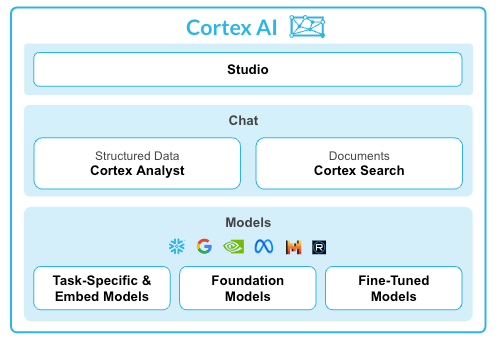

そこで登場するのがSnowflakeです。Snowflake Cortex AIは、技術的な専門知識に関係なく、組織内のすべての人がテクノロジーの可能性を解き放つように設計されたフルマネージド型のサービスです。業界をリードする大規模言語モデル(LLM)へのアクセスを提供し、ユーザーはAIを活用したアプリケーションを簡単に構築、展開できます。Cortexを使用することで、企業はAIを統制されたデータに直接持ち込み、モデルへのアクセスとガバナンスポリシーを迅速に拡張できます。

先日Cortex AIのアップデートを発表しました。これには、基盤モデルと埋め込みモデルへのサーバーレス アクセスを提供するLLM関数の一般提供が含まれます。

企業が生成AIを効率的、簡単、信頼のおける方法で活用できるよう、私たちはCortex AIに以下の新しいコンポーネントを導入します。

- Cortex Analyst(近日中にパブリックプレビュー開始): ビジネスユーザーが自然言語を使用して構造化データを操作できるようにし、より迅速に答えを見つけ、インサイトをセルフサービスで取得し、貴重な時間を節約できるようにする

- Cortex Search(近日中にパブリックプレビュー開始): 最新のArctic埋め込みモデルを使用して、特定のエンタープライズ・ドキュメント・セット内で質問をすることにより、迅速かつ安全に情報を検索。

- Cortexファインチューニング(パブリックプレビュー): サーバーレスのファインチューニングを使用して、LLMを安全かつ簡単にカスタマイズし、ユースケース固有のタスクのモデル精度とパフォーマンスを向上させます。ファインチューニングされたモデルは、Snowflakeモデルレジストリを使用して管理できます。

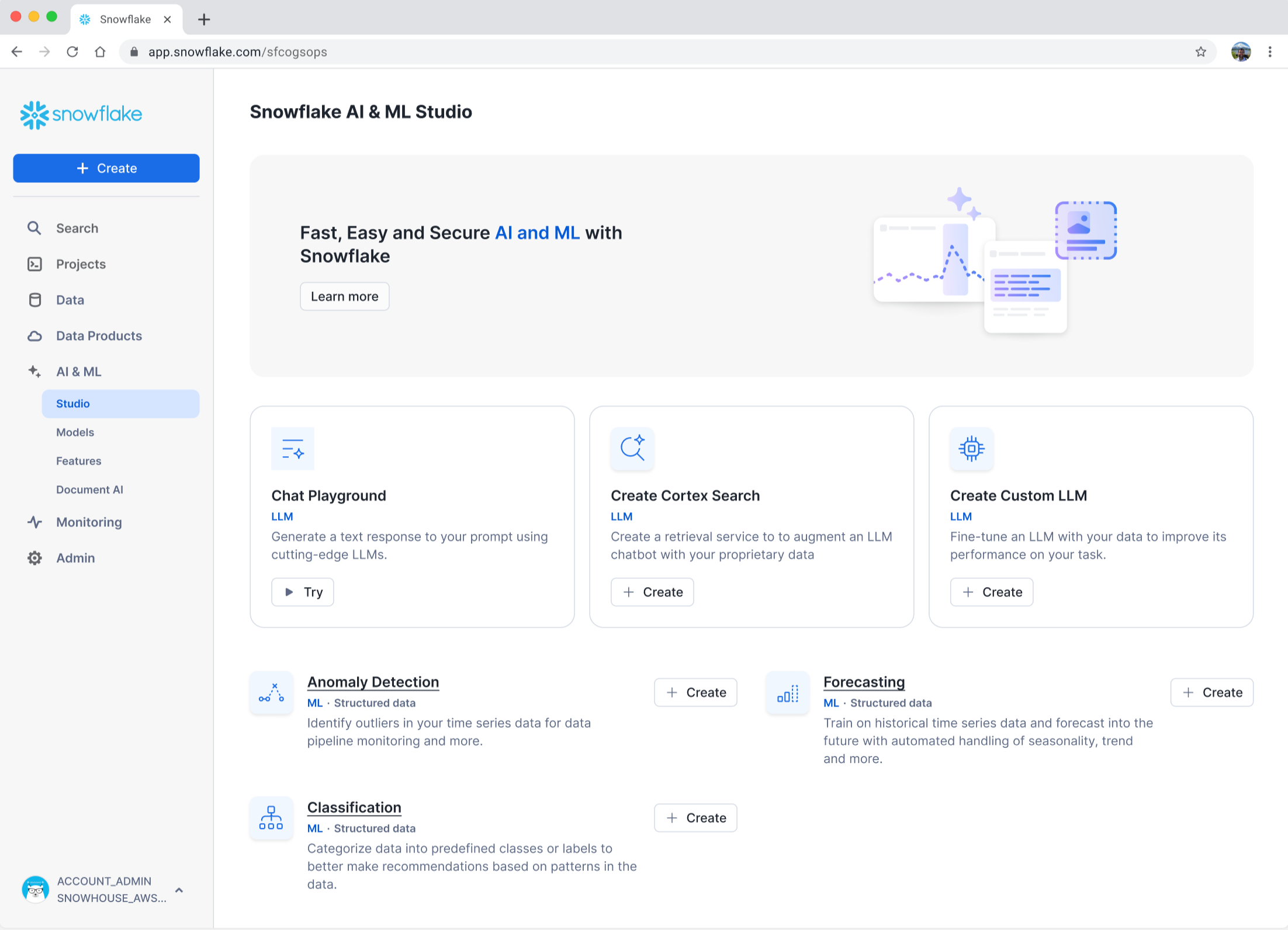

- LLM向けSnowflake AI & ML Studio(プライベートプレビュー中): あらゆる技術レベルのユーザーがノーコード開発でAIを活用できるようにするMLモデル開発については、現在パブリックプレビュー中です。

- Snowflake Cortex Guard(近日中に一般提供開始): LLMベースのセーフガードを使用して有害コンテンツをフィルタリングし、フラグを立てることで、モデルの安全性とユーザビリティを確保します。

その他の機能強化としては、Cortex AI機能を任意のアプリケーションでプログラム的に統合するREST APIの追加や、AI21ラボモデルのサポート(近日公開予定)などがあります。

「Snowflake Cortex AIにより、高度なLLMのパワーを使用してデータからインサイトを大規模に抽出する方法が変わりました。当社のチームは、膨大なデータセットを迅速かつ安全に分析できるようになり、戦略的インサイトを活用してクライアントにより良いサービスを提供できるようになりました。Snowflakeの新しいAI機能により、処理時間が40分の1に短縮されました」 - Jennifer Brussow氏、Terakeet、データサイエンス担当ディレクター

それぞれのアップデートの詳細は以下のとおりです。

Cortex Analyst:ビジネスユーザーがチャットでデータにアクセスし、AIを使用してテキストから回答までのインサイトを取得できるようにする

MetaのLlama 3およびMistral Largeモデルで構築されたCortex Analystを使用すると、自然言語で質問するだけで、構造化データから必要なインサイトを得ることができます。Cortex Analystを使用すると、アプリ開発者はSnowflakeに保存された分析データに基づいてビジネスユーザー向けのアプリケーションを開発できます。開発者は、データサイロを解消し、組織内の全員がデータから迅速に回答やインサイトにアクセスできるようにするAIを活用した会話型データアプリケーションを開発できます。

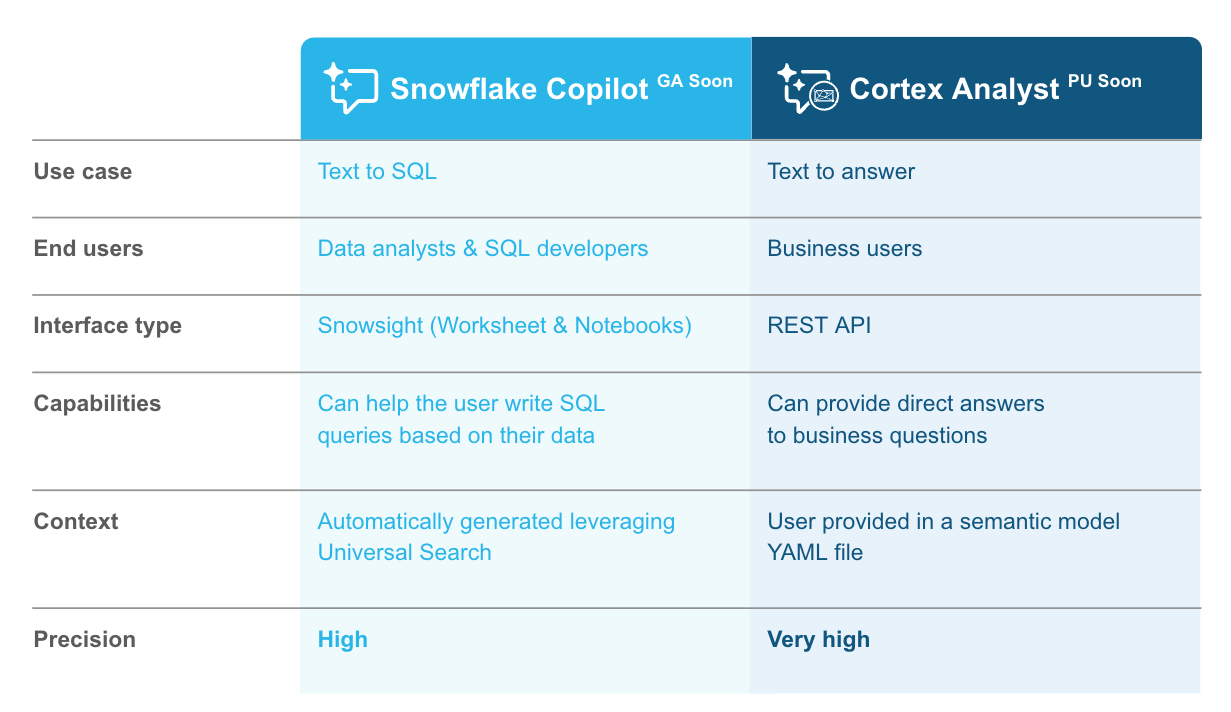

Cortex Analystは、あらゆるユーザーがSnowflake内で答えを見つけるのに役立つよう設計されています。セルフサービス型のデータインサイトと意思決定により、チームがより迅速かつ効率的に業務を行えるようサポートします。ビジネスチームが信頼できる高精度の結果を提供するために、Cortex Analystはビジネスに合わせてセマンティックモデルを使用して、組織のコンテキストで使用される特定の用語とデータ構造を把握し、より正確で関連性の高い結果をもたらします。

Snowflake Cortex Analystは、対話するあらゆるアプリケーションから質問し、必要な回答を得られるように設計されています。SQL開発者がテキストをSQLに変換してSnowflake UI内から開発を促進するSnowflake Copilotアシスタントとは対照的に、Snowflake Copilotはビジネスのもう一つの役割を担います。

Cortex Search:効率的かつ正確なエンタープライズグレードの文書検索とチャットボットを提供する

Cortex Searchは、非構造化データやドキュメントのインデックス作成やクエリを行う豊富な機能を備えたフルマネージド型検索ソリューションです。Cortex Searchは、データの取り込み、埋め込み、取得、リランキング、生成のためのエンドツーエンドのワークフローを管理します。埋め込みプロセスは完全に自動化されており、簡単に設定できます。最先端のハイブリッド検索により、より良い結果が得られます。

Cortex Searchは、アプリケーションでの検索の実装と統合を簡素化します。具体的な内容:

1.統合されたドキュメントの前処理: ファイルからテキストを抽出し(PDFからテキストへ)、テキストをインデックス作成前にチャンクに分割するプロセスを合理化するために、Snowflake Cortexは近日中に2つのマネージド関数をプライベートプレビューで追加する予定です。このような前処理により、開発者は埋め込み前にテキストを準備するために必要なカスタム関数を実装したり展開したりする必要がなくなります。

2.フルマネージド型のベクトル埋め込みと管理:Cortex Searchでは、ベクトル埋め込みの生成に個別のAPIやサービスは必要ありません。これにより、テキストをベクトル形式に変換するために必要なオーバーヘッドが排除されます。Snowflakeデータ処理インフラストラクチャーを使用し、新しいドキュメントの生成時の継続的な更新を自動化することで、サービスを最新の状態に維持します。

3.最先端の検索とランキング: より正確な結果を得るために、Cortex Searchは最新の検索およびランキング技術を使用します。Neevaの最新のテクノロジーとSnowflake AIリサーチチームが開発したArctic埋め込みモデルを土台として構築されたセマンティック検索とキーワード検索の組み合わせにより、Cortex Searchは運用の複雑さに煩わされることなく高品質の結果をユーザーに提供できるようになりました。バックグラウンドでは、Snowflake Cortexが並行して検索を行い、結果をマージしてランク付けすることで、関連するドキュメント情報に基づいた正確な出力を行います。

4.セキュリティとガバナンス: Cortex SearchはSnowflakeのプラットフォームに統合されているため、一貫したガバナンスポリシーを生ドキュメントとベクトル埋め込みの両方に適用できます。これにより、データリスクが最小化され、別々のデータセキュリティフレームワークの維持にかかる時間が短縮されます。

Cortex Searchは、フルマネージド型のベクトルと検索により、非公開の最新情報をLLMに取得してより正確な結果を得るために使用される検索拡張生成(RAG)アーキテクチャを合理化します。このモデルでは、Cortex Searchは入力された質問に基づいて、まずナレッジソースから関連するドキュメントや文章を取得します。その後、関連する結果セットをSnowflake CortexのLLMに渡し、状況に応じた正確な応答を生成できます。

Cortex Searchは、RAGベースのチャットボットの開発を簡略化するだけでなく、大量のドキュメントコーパスに散らばった情報を定期的に検索するチームの生産性を高めることができます。具体的には、次のことを実行できます。

1.ニードルインアヘイスタックルックアップ: 膨大な量のドキュメントに潜む答えを見つける。

2.マルチドキュメント合成と推論: 複数のドキュメントにまたがっている質問への回答を調達します。たとえば、「2022年から2023年の間に、私の会社の収益はどのように成長しましたか?」と尋ねることができます。

3.表形式データ、図形合成: データベースやスプレッドシートなどの一般的なデータストレージシステムで特にフォーマットされたデータなど、データ内の非自由な構造から回答を得ることができます。

Cortexファインチューニング:LLMのカスタマイズを簡略化し、コスト効率の高いユースケースアプリケーションを実現

Cortexファインチューニングでは、MetaとMistral AIの業界をリードするモデルをファインチューニングできます。簡単に言うと、AIモデルのファインチューニングとは、特定のタスクやデータセットのパフォーマンスを改善するためにモデルに小さな修正を加えることです。これにより、開発者は要約などの特定のタスクの精度を高めたり、作業中のタスクのアウトプットを改善したりできます。Cortex Fine-Tuningでは、比較的小さなベースモデルをファインチューニングし、大きなモデルと同じ精度を得ることができます。繰り返し行われる特殊なタスクに対してこれを行うことで、推論レイテンシーとコストを低減できます。

Cortexファインチューニングでは、APIまたはSQL関数を呼び出すことで、インフラストラクチャーを管理する手間をかけずにファインチューニングできます。ベースモデルを選択し、トレーニングデータセットを提供するだけで、Cortexがファインチューニングされたモデルを作成してくれます。ファインチューニングされたモデルが利用可能になったら、それをアプリケーションに統合できます。ファインチューニングされたモデルは、Snowflakeロールベースアクセス制御(RBAC)を使用してモデルへのアクセスを管理できるため、安全です。

ファインチューニングジョブが完了すると、他のLLMと同様に、Cortex COMPLETEでモデルにアクセスできます。

Snowflake AI & ML Studio:あらゆる技術レベルのユーザーがノーコード開発でAIを活用できるようにする

Snowflakeは、あらゆるスキルレベルのユーザーがAIにアクセスできるようにします。Studioでは、開発者はLLMの試用、データによるモデルのファインチューニング、ドキュメントの操作をすべてコンソールで簡単に行うことができます。また、開発者の生産性を向上させることで、アプリケーションの迅速な提供も実現します。

Snowflake AI Studioからできること:

- 複数のLLMで補完を比較(プライベートプレビュー中):ビジネスユーザーは、チャットプレイグラウンドを使用して、LLMモデルを簡単にテストおよび評価し、自社固有のニーズに最適なコスト効率の高いものを見つけることができます。これにより、ユーザーはアプリケーションに使用する適切な設定とLLMを迅速に特定し、生産性を向上させることができます。

- UIによるLLMのファインチューニング(プライベートプレビュー中):ユーザーは、使いやすいUIでモデルをファインチューニングできるようになります。ユーザーは、Studioのノーコードのクリックスルーエクスペリエンスを通じて、またはコードを好む場合は指定されたファインチューニング機能を通じて、カスタムモデルを開発できます。

さらに、ユーザーは事前に構築されたチャットインターフェースを使用して、<Cortex Searchで構築された既存のインデックス付きドキュメントセットに対して質問することができます。

Snowflake Cortex Guard:LLMベースの保護機能により、モデルの安全性とユーザビリティを確保

Snowflakeは、MetaのLlama Guardを使用して有害なコンテンツをフィルタリングし、フラグを立てることでモデルの安全性とユーザビリティを確保する新機能であるCortex Guardの提供を開始します。Cortex Guardは、AIアプリケーションを本番環境にデプロイするにはAIの安全性が不可欠であるとお客様から言われたことから構築しました。たとえば、企業は自社のサービスや最終的にはビジネスに影響を与える安全でない可能性のあるAI応答から、自社のユーザー向けアプリケーションを保護したいと考えています。新しいCortex Guard機能は、これらのユースケース専用です。Cortex Guardは、言語モデルの応答を評価してから、その出力をアプリケーションに返します。顧客は、COMPLETE関数内で利用可能な新しいCortex Guardパラメータをワンクリックで有効化できるようになりました。

LLM向けCortex REST API:Cortex AIにあらゆるアプリから簡単にアクセスできるようにする

REST API(近日公開予定)により、アプリケーションからCortex上のLLMにプログラムからアクセスできます。プロンプトを設定し、LLMのいずれかを使用して推論を実行できます。あるいは、テキストの要約、センチメントの特定、入力の変換をあらかじめ用意されている関数から選択することもできます。

生成AIにより、企業はデータを最大限に活用し、全体的な効率を高めることができます。Snowflake Cortex AIを利用すると、企業はチャットなどで生成AI機能を簡単に活用できます。

すべての従業員が安全な環境でAIアプリケーションを簡単に構築、展開するために必要なツールとインフラストラクチャーが追加されました。Snowflake Cortex AIでこれらのAIアプリを構築することにより、より充実した情報に基づく意思決定を促進し、オペレーションを最適化し、顧客やステークホルダーにパーソナライズされたエクスペリエンスを提供できるようになりました。Snowflakeは、お客様のような企業が生成AIの可能性を簡単、効率的、安全に引き出すことを可能にしました。

Snowflake Cortex AIの利用を開始するには、次のいずれかのクイックスタートをお試しください。

- バッチテキスト処理:

- RAGベースのチャットボット:

ビジネスや業界固有のユースケースの開発を促進するために、Snowflakeのお客様は信頼できるパートナーを通じてCortex AIにアクセスできます。こちらをクリックし、Snowflake Cortexのウェブページでソリューションの詳細をご確認ください。