Condividere e monetizzare i modelli AI in modo sicuro nell’AI Data Cloud

L’avvento dei modelli di AI generativa sta spingendo le organizzazioni a incorporare l’AI e i large language model (LLM) nella propria strategia aziendale. Dopo tutto, questi modelli aprono le porte a nuove opportunità per estrarre più valore dai dati e dalla proprietà intellettuale di un’azienda e renderli accessibili a un pubblico più ampio in tutta l’organizzazione.

Una chiave per sfruttare con successo i modelli Gen AI è la capacità di condividere i dati. Le aziende con dati preziosi che possono essere utilizzati per il fine‐tuning dei LLM vogliono poterli monetizzare e utilizzare per il fine‐tuning senza concedere l’accesso alle fonti di dati originali. Vogliono anche assicurarsi che ogni utilizzo sia attribuito in modo appropriato a loro.

Purtroppo, molte delle soluzioni attualmente disponibili non offrono alle aziende gli strumenti necessari per condividere i dati in modo sicuro e garantire allo stesso tempo:

Che i preziosi dati di un’organizzazione siano sempre gestiti da tale organizzazione e non resi disponibili ad altre parti, il che potrebbe comportare un utilizzo inappropriato o potenzialmente dannoso

Che i modelli di terze parti utilizzati all’interno dell’azienda siano protetti all’interno di sandbox sicure

Un attento monitoraggio dell’accesso a dati e modelli

Noi di Snowflake stiamo affrontando queste sfide con decisione, semplificando la possibilità per gli sviluppatori di utilizzare un’AI affidabile con i dati aziendali.

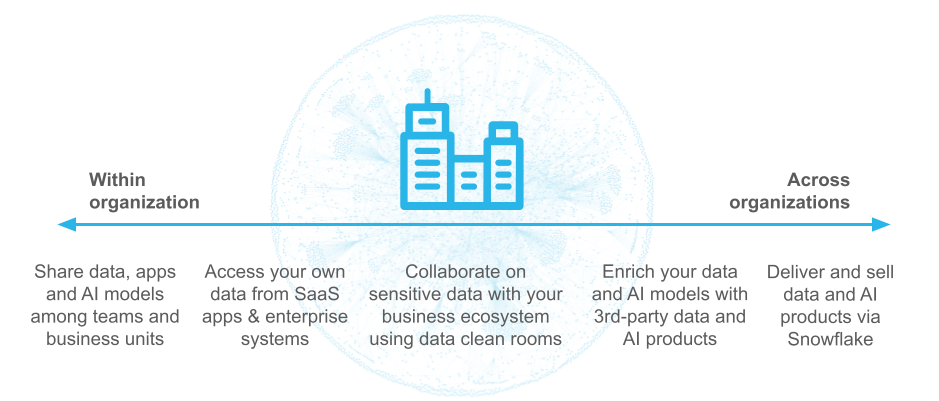

Alla nostra recente conferenza per sviluppatori BUILD 2024, abbiamo evidenziato tre funzionalità per aiutarvi a condividere i vostri LLM ottimizzati, condividere i data set per addestrare i vostri LLM e condividere i modelli AI/ML tradizionali in modo sicuro all’interno e all’esterno dell’organizzazione in tutto l’AI Data Cloud. Abbiamo fornito una panoramica di queste funzionalità in un blog precedente, ma vediamo ora come è possibile utilizzarle nei tuoi progetti.

Snowflake Cortex AI: LLM ottimizzati di Meta e Mistral AI

Per sfruttare appieno i modelli AI fondamentali, le aziende devono personalizzarli e ottimizzarli in base ai loro domini e data set specifici. Questo comporta generalmente due obblighi: nessun dato deve lasciare la sede in qualsiasi momento e nessun investimento pesante deve avvenire nella costruzione dell’infrastruttura.

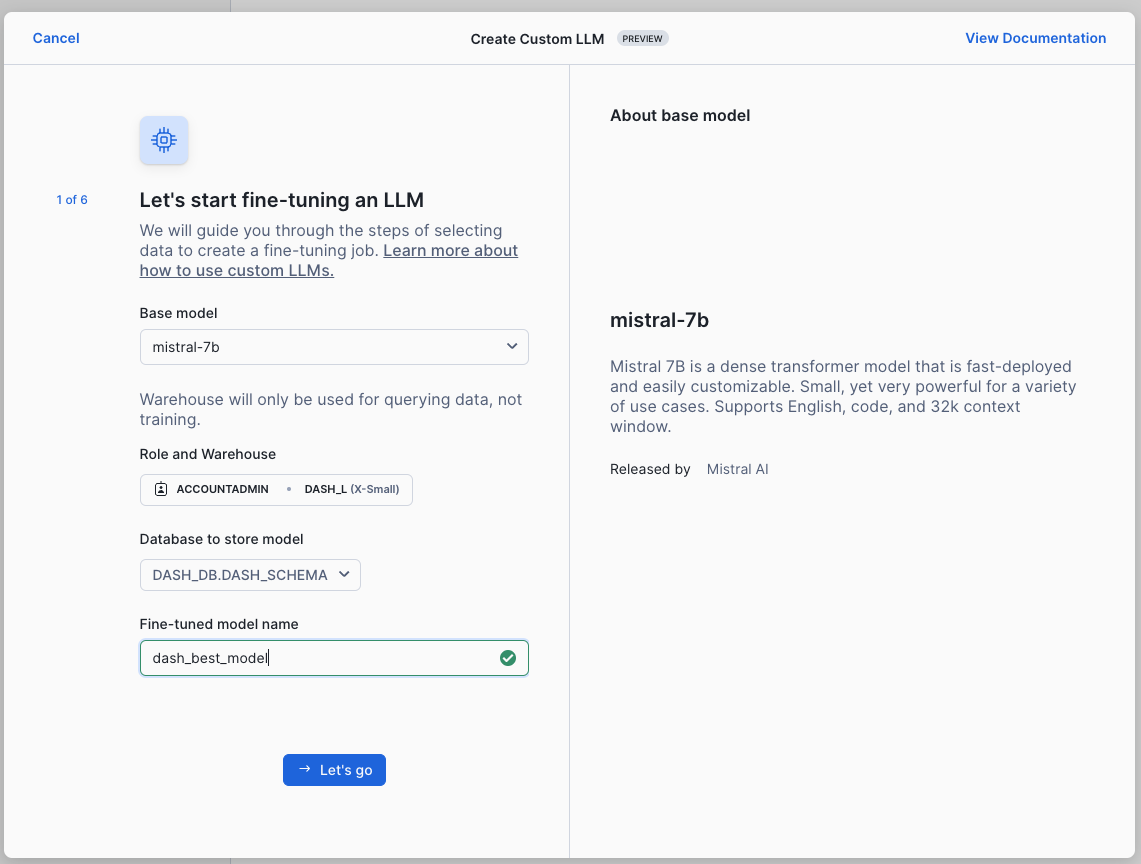

Snowflake ora offre alle aziende la possibilità di ottimizzare i modelli leader di Meta e Mistral AI utilizzando i dati all’interno del proprio perimetro di sicurezza e senza dover gestire alcuna infrastruttura. Anzi, gli sviluppatori possono facilmente governare e gestire i propri LLM personalizzati con Snowflake Model Registry.

Con Secure Model Sharing (attualmente in public preview), puoi ottimizzare e condividere modelli di base personalizzati in tre passaggi:

Seleziona il modello base e fornisci il tuo data set di addestramento come parte della funzione FINETUNE o utilizzando l’esperienza no-code in Snowflake AI & ML Studio. I modelli ottimizzati possono essere utilizzati tramite la funzione COMPLETE.

Condividi i tuoi modelli ottimizzati in modo sicuro con altri account Snowflake nella tua regione.

Replica i tuoi modelli ottimizzati tra regioni all’interno dell’organizzazione.

SNOWFLAKE.CORTEX.FINETUNE(

‘CREATE’

<model_name>,

<base_model>,

<training_data>,

<validation_data>

);

Sfrutta la potenza dei LLM Cortex con Cortex Knowledge Extensions

Le aziende vogliono un modo semplice per integrare i propri modelli di base con informazioni specifiche per il proprio settore per ottenere risposte più pertinenti. Tradizionalmente, occorre molto tempo e impegno per trovare e procurare i data set giusti, e poi più tempo e competenze tecniche per preparare i dati per il consumo e ottimizzare i LLM. Snowflake ha già semplificato la prima parte di questo processo, ossia la localizzazione dei dati appropriati, con il Marketplace Snowflake, che offre un unico posto centrale per trovare, provare e acquistare rapidamente più di 2900 data set, app e data product (al 31 ottobre 2024). Ora, con Cortex Knowledge Extensions (attualmente in private preview), rendiamo più facile preparare e trasformare i dati di terze parti.

Le Cortex Knowledge Extensions offrono ai clienti un “semplice pulsante” per ampliare il modello di base scelto con informazioni aggiornate riferite a un particolare dominio, senza richiedere ulteriori competenze tecniche per ottimizzare e massaggiare i dati grezzi di un provider di contenuti. Fondamentalmente, i clienti avranno la certezza di utilizzare contenuti con licenza ufficiale.

Cortex Knowledge Extensions consente alle applicazioni Gen AI di trarre risposte dai dati non strutturati e con licenza dei provider, attribuendo loro l’attribuzione appropriata e isolando dall’esposizione il data set completo originale. Questo aiuta i provider a monetizzare la Gen AI riducendo al minimo il rischio che i loro contenuti vengano utilizzati per l’addestramento dei modelli.

Per rendere disponibili i propri dati sul Marketplace Snowflake, il provider di contenuti imposta un servizio Cortex Search sui propri dati e li pubblica sul Marketplace Snowflake. Dopo la pubblicazione, il consumatore può trovare il listing e acquisire i dati dal Marketplace Snowflake. I data consumer possono quindi utilizzare le API AI Cortex per richiedere ai LLM i dati acquisiti nel Marketplace Snowflake.

Condividi i modelli AI/ML tradizionali nell’AI Data Cloud

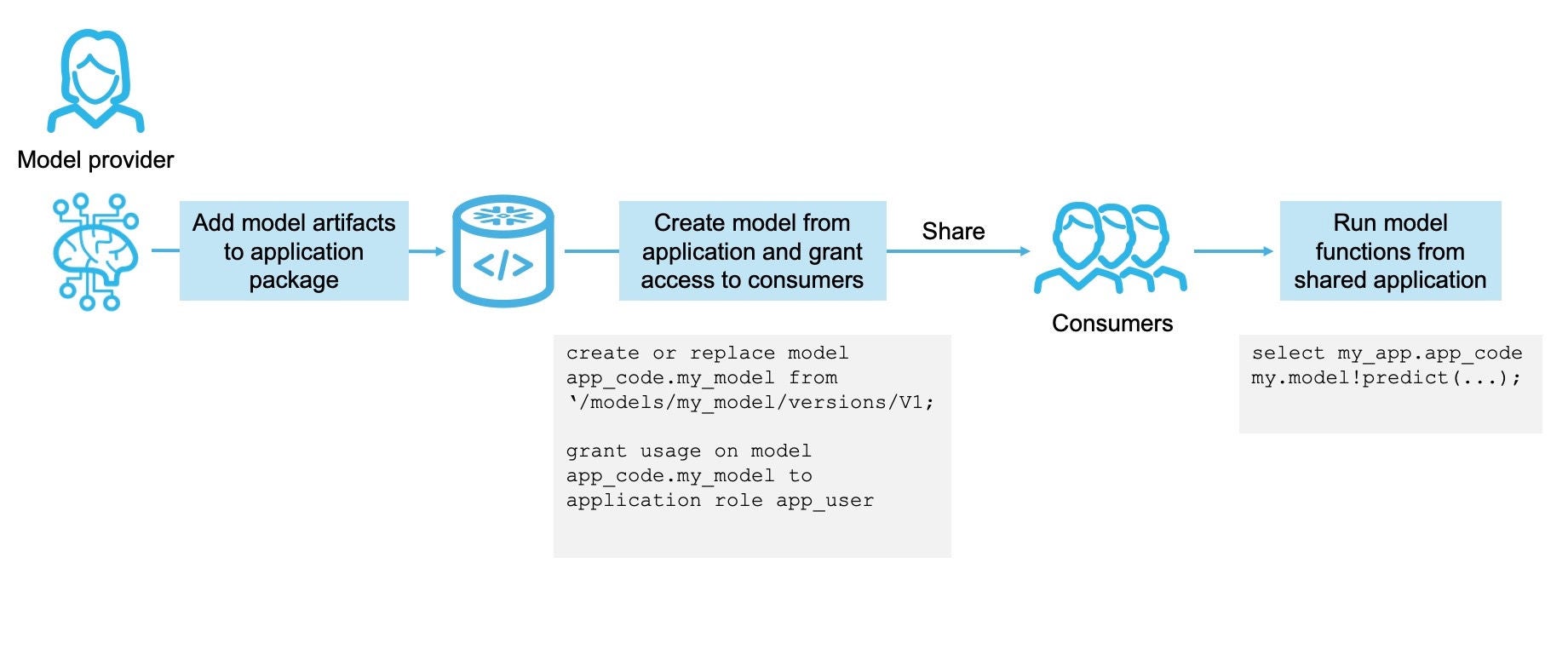

Sempre più aziende stanno creando modelli AI/ML personalizzati per attività specifiche come la previsione dell’abbandono o dei ricavi. Questi modelli possono essere sviluppati all’interno dell’organizzazione da data scientist o da partner esterni. Ora le aziende possono sbloccare la potenza di questi modelli e condividerli con partner, clienti e utenti all’interno dell’azienda utilizzando Snowflake Native Apps sia sul Marketplace interno che sul Marketplace Snowflake rivolto all’esterno.

Con il Secure Data Sharing Snowflake, le organizzazioni possono consentire agli utenti finali di eseguire modelli ML in modo sicuro grazie a un controllo degli accessi granulare basato sui ruoli sui propri dati. I dati veri e propri non lasciano mai i confini di sicurezza dell’organizzazione. La pacchettizzazione dei modelli con Snowflake Native Apps garantisce che essi ereditino la postura di sicurezza di Snowflake Native Apps, tra cui scansione di sicurezza, sandboxing e accesso a risorse locali o esterne in base a specifici privilegi concessi al modello.

Condividere un modello è semplice come aggiungere artefatti del modello a un pacchetto di applicazione e concedere privilegi di utilizzo specifici per l’applicazione. Gli utenti sono poi liberi di installare l’applicazione e invocare le funzioni del modello.

Con la collaboration e il data sharing Snowflake, le aziende possono creare e condividere facilmente modelli AI/ML, sia tradizionali che LLM ottimizzati, e condividerne i vantaggi con il resto dell’azienda. Per saperne di più e provare alcune di queste funzionalità, dai un’occhiata a queste risorse: