WORKLOADS

Snowflake pour le Data engineering

Créez des pipelines de données par batch et en continu puissants en SQL ou Python.

Réduisez la complexité des exigences de data engineering

Créez des pipelines de données par batch et en continu dans une plateforme unique, grâce aux pipelines déclaratifs et à une actualisation incrémentielle rentable.

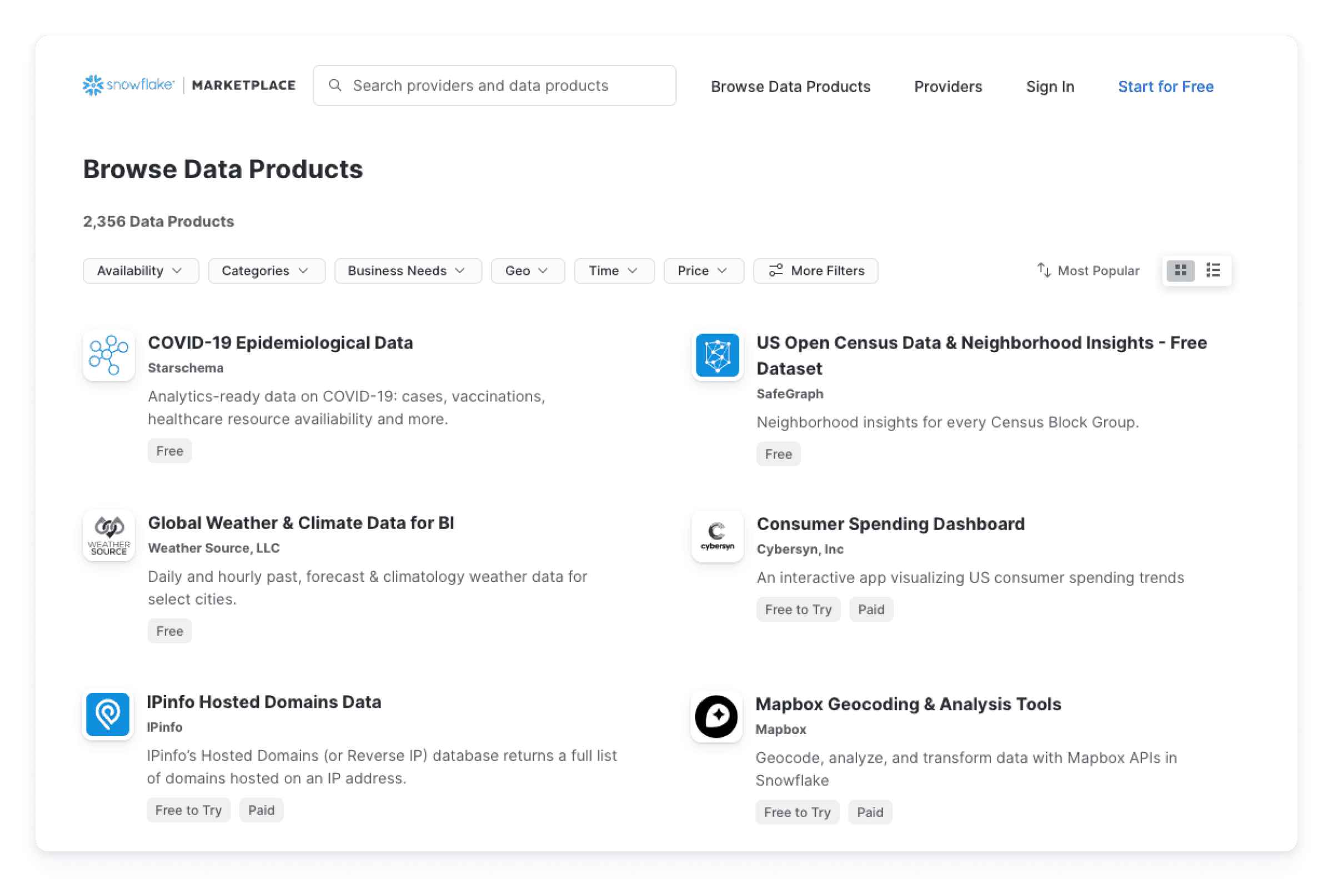

Éliminez les pipelines inutiles grâce au partage de données

Accédez à des données actualisées et prêtes à l’emploi directement à partir de milliers d’ensembles de données et d’applications via la Marketplace Snowflake, sans création de pipelines.

Codez dans votre langage préféré au sein d’un moteur optimisé unique

Programmez en Python, en SQL et dans d’autres langages, puis exécutez votre code avec le calcul multi-cluster de Snowflake. Aucune infrastructure distincte n’est requise.

Comment ça marche ?

Diffusez des données avec une latence inférieure à 10 secondes

Souvent conservés séparément, les systèmes en continu et par batch sont généralement difficiles à gérer, tandis que leur dimensionnement peut s’avérer coûteux. Cependant, Snowflake simplifie ce processus en gérant l’ingestion des données et leur transformation, aussi bien par batch qu’en continu, au sein d’un même système.

Diffusez des données tabulaires en continu et en temps quasi réel avec une latence inférieure à 10 s via Snowpipe Streaming, ou optez pour l’ingestion automatique avec Snowpipe. Chacune de ses solutions fonctionne sans serveur, garantissant une meilleure évolutivité et une rentabilité accrue.

Ajustez la latence en modifiant un seul paramètre

Grâce aux Dynamic Tables (en public preview), vous pouvez utiliser SQL ou Python pour définir des transformations de données de façon déclarative. Snowflake gérera les dépendances et matérialisera automatiquement les résultats en fonction de vos objectifs d’actualisation des données. Afin de rendre les volumes de données élevés et les pipelines complexes plus simples et plus rentables, les Dynamic Tables se concentrent sur les données ayant connu un changement depuis la dernière actualisation.

Les besoins de votre activité ne cessant d’évoluer, l’adaptation est facilitée par la création d’un pipeline par batch au sein d’un pipeline en continu, grâce à la modification d’un seul paramètre de latence.

Dynamisez le data engineering pour les analyses, les applications, l’IA et le ML

Rapprochez vos workloads de vos données afin de rationaliser votre architecture de pipelines et de vous affranchir de la nécessité d’une infrastructure distincte.

Intégrez votre code à vos données afin de répondre aux divers besoins de votre activité, qu’il s’agisse d’accélérer les analyses, de créer des applications ou encore d’exploiter tout le potentiel de l’IA générative et des LLM. Grâce à Snowpark, vous pouvez créer ce code dans le langage de votre choix, que ce soit SQL, Python, Java ou Scala.

Performances 3,5 fois supérieures et coûts 34 % inférieurs, sans compromis sur la gouvernance

Codez avec Python, Java ou Scala en utilisant les bibliothèques de Snowpark, telles que les API DataFrame, ainsi que ses environnements d’exécution, notamment les UDF et les procédures stockées. Ensuite, déployez et traitez votre code en toute sécurité à l’emplacement de vos données, en bénéficiant d’une gouvernance constante dans Snowflake.

Avec Snowpark, nos clients constatent des performances médianes 3,5 fois supérieures et des coûts 34 % inférieurs à ceux des solutions Spark gérées1.

Construisez moins de pipelines de données grâce à un partage de données simplifié

Avec le Data Cloud, accédez facilement à un vaste réseau de données et d’applications.

Accédez à vos données et applications et distribuez-les en toute simplicité grâce à un accès direct à des ensembles de données actualisées provenant de la Marketplace Snowflake. Vous bénéficierez ainsi d’une réduction de vos coûts et charges associés aux pipelines d’extraction, de transformation et de chargement (ETL) traditionnels, ainsi qu’aux intégrations basées sur les API. Vous avez également la possibilité d’intégrer vos données à l’aide de connecteurs natifs.

NOS CLIENTS

Les leaders utilisent Snowflakepour le data engineering

Premierspas

Toutes les ressources de data engineering dont vous avez besoin pour créer des pipelines avec Snowflake.

Quickstarts

Lancez-vous rapidement grâce aux tutoriels Snowflake dédiés au data engineering.

Atelier pratique virtuel

Participez à un atelier pratique virtuel et animé par un instructeur pour apprendre à construire des pipelines de données avec Snowflake.

Communauté Snowflake

Rencontrez un réseau mondial de professionnels de la data, et bénéficiez de leur expérience, dans le forum communautaire de Snowflake et dans les Snowflake User Groups.

Démarrez votre essaigratuit de 30 jours

Essayez Snowflake gratuitement pendant 30 jours et découvrez le Data Cloud qui élimine la complexité, les coûts et les contraintes d’autres solutions.

1Source de données : Résultats pour les clients de Snowpark